2주차로 돌아왔습니다. 1주차는 개념 맛보기 느낌이었다면 2주차부터는 본격적으로 개념에 대해서 배우기 시작합니다.

2-(1) Binary Classification

2-(1)에서는 Binary Classification에 대해서 배운다. 사실 영어로 쓰면 뭐든 있어보이고 어려워보이지만 아무런 개념도 아니다. 두 가지로 분류한다는 뜻이다.

고려대학교 이캠의 상징인 귀여운 버찌를 예로 들어 보겠다.컴퓨터가 이 사진을 고양이로 인식하면 1, 아니면 0으로 분류하겠다는 것이다.

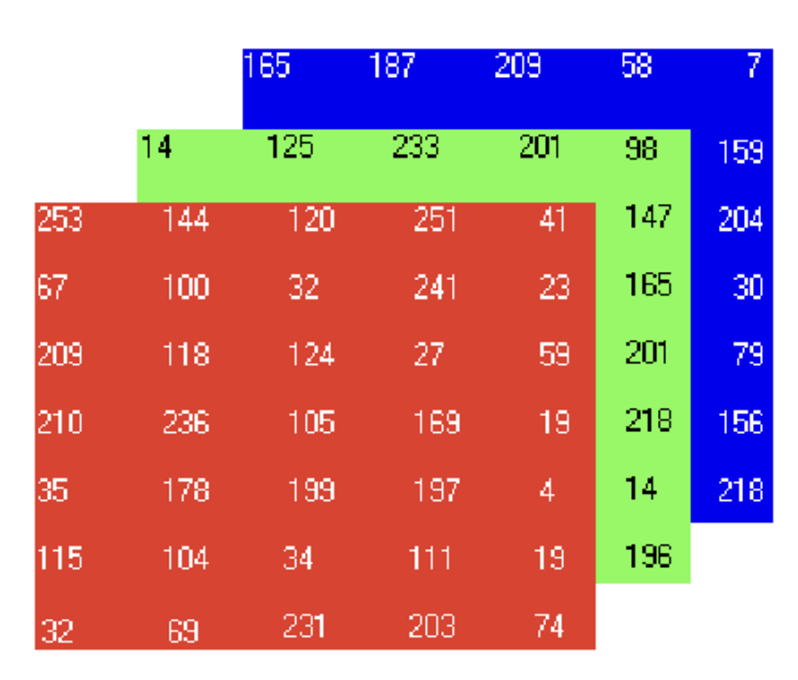

이미지는 숫자 정보가 픽셀 단위(pixel value)로 저장 되어있다.

64x64 데이터는 64*64*3의 크기를 갖기에 행렬에서 Nx=12288이 된다.(행의 개수)

하나의 데이터는 feature 벡터로 하나의 열에 저장이 된다.인풋 데이터 x는 다음과 같이 저장되고,

아웃풋 y는 다음과 같이 저장 되는 것이다.

사진 설명을 입력하세요.

2-(2) Logistic Regression

Binary Classification에서 값이 0인지1 인지 확인하고 싶을 때 사용하는 식이다.

y^은 x가 주어졌을 때 y의 예측 값을 의미한다. Binary Classification에서 특정 값이 될 확률을 의미하기 때문에 0에서 1 사이에 속한다.

예측 값을 추정하기 위한 파라미터로는 w로 b를 사용한다. 앞에서 언급한 인풋 데이터는 행의 개수가 n_x이기 때문에 R nx에 속한다. 파라미터 w 또한 같은 차원에 속하도록 설정한다.

그럼 y^는 wTx +b라는 식을 통해 인풋 데이터가 주어졌을 때 예측값을 구할 수 있다. (w와 b를 구하는 과정에 대해서는 추후에 설명)

다만 여기에서 하나의 문제가 생긴다. 결과값이 0에서 1사이의 값이 된다는 보장이 없기 때문이다. 그렇기 때문에 0에서 1 사이만을 치역으로 갖는 함수의 정의역 값으로 wTx +b을 넣어준다. 이때 0에서 1 사이만을 치역으로 갖는 함수를 시그모이드 함수로 설정한다.

마이너스 무한대로 갈 시 0에 수렴하고, 무한대로 갈 시에 1에 수렴하므로 치역만 확인하면 적절한 함수라는 것을 알 수 있다.(최근에는 많이 사용되지 않는다고 하는데 이유는 나중에 알려주신단다.)

2-(3) Logistic Regression Cost Function

이 강의에서는 Logistic Regression에서 활용되는 식들을 몇 개 다룬다.

2-(3) 강의에서 인덱스 정도만 추가된 것으로, 리마인드 차원에서 알려주신다.

이후엔 Loss Function에 대한 개념이 제시가 된다.

Loss Function은 오차값을 측정하는 함수이다. Logistic Regression 자체가 예측값을 구하는 과정이기에, 오차가 필연적으로 존재할 수 밖에 없다. 이를 줄이기 위해서 Loss Function을 활용하는 것이다.

이러한 함수를 예로 들 수 있겠다. 작으면 작을수록 Logistic Regression의 결과가 정확한 것이다. 그런데 이 식은 사용하지 않는다고 한다. 이유는 또 나중에 알려주신다고 한다..

Logistic Regression에서 실제 사용 되는 Loss Function은 다음과 같다.

직관만을 활용하여 설명을 해주셨고, 증명은 또 나중에...알려주신다고 한다.

이 식은 예측값 하나만을 대상으로 하기에 데이터 한 개를 대상으로 오차를 측정한 것이다.

Cost function은 이들의 평균값을 구하는 것이다. 항상 제일 작은 값을 구하는 것이 목표인 것이다.

'Andrew Ng(Deep Learning)' 카테고리의 다른 글

| 앤드류응 교수님 딥러닝 학습일지 실습-(2) (부제:야옹~난 고양이야!) (1) | 2023.06.05 |

|---|---|

| 앤드류 응 교수님 딥러닝 학습일지 실습(1) (0) | 2023.06.05 |

| 앤드류 응 교수 딥러닝 학습일지-(4) (0) | 2023.06.05 |

| 앤드류 응 교수 딥러닝 학습일지-(3) (0) | 2023.06.05 |

| 앤드류 응 교수 딥러닝 학습일지-(1) (0) | 2023.06.05 |